aiDAPTIV+가 SMB 미세 조정 LLM의 어려움을 해결하는 방법

aiDAPTIV+는 높은 가격과 복잡성 없이 LLM의 강력한 기능을 활용하려는 중소기업을 위한 게임 체인저로 부상하고 있습니다. 비용 효율성, 플러그 앤 플레이 스타일의 사용 용이성 및 낮은 전력 소비를 염두에 두고 설계된 aiDAPTIV+는 기업이 워크스테이션급 시스템에서 더 큰 모델을 효과적으로 교육할 수 있도록 지원합니다. 광범위한 인프라나 전문 교육이 필요하지 않음으로써 중소기업은 이제 이전에는 불가능했던 AI 기반 솔루션을 혁신하고 개발하는 데 집중할 수 있습니다.

aiDAPTIV+ 작동 방식

aiDAPTIV+의 핵심에는 내구성이 뛰어난 SSD로 구성된 혁신적인 aiDAPTIVCache 제품군이 있습니다. 이 ai100 SSD는 NVMe 오프로드를 촉진하여 2~4개의 워크스테이션급 GPU와 표준 DRAM만으로 대규모 모델을 효율적으로 훈련할 수 있습니다. 이는 스토리지와 컴퓨팅 리소스 간의 데이터 흐름을 최적화하여 성능을 크게 향상시키고 훈련 시간을 단축하며 대규모 모델 훈련을 가능하게 하는 aiDAPTIV 관리 소프트웨어로 보완됩니다.

표준화된 성능

“지난해 단 하나의 중요한 사건이자 이 사건이 이곳 이 지역의 AI 연구자들을 어떻게 활성화했는지는 실제로 Llama-2입니다. 이는 오픈 소스 모델입니다.”

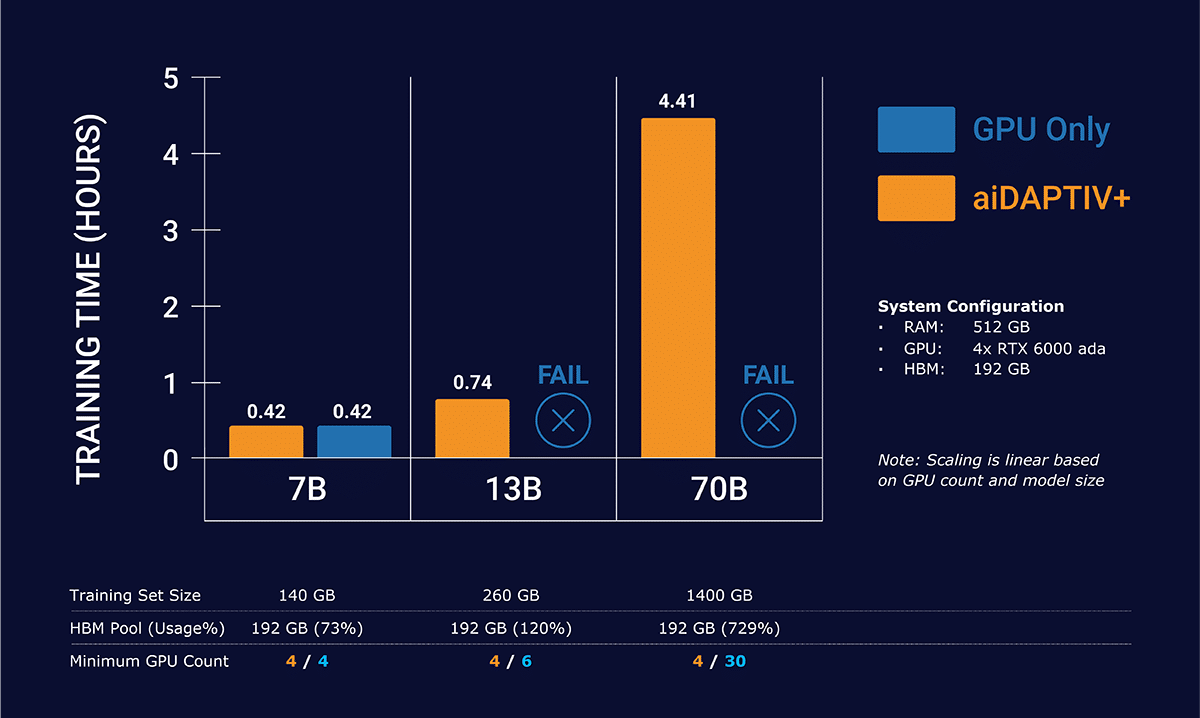

Llama-2 모델을 사용한 aiDAPTIV+의 성능은 효율성과 효율성을 입증합니다. 다양한 모델 크기에 걸쳐 단일 시대의 훈련 시간이 크게 단축되었습니다.

aiDAPTIV+는 선형 스케일링으로 더 큰 모델을 훈련합니다.

GPU와 GPU + aiDAPTIV+를 비교한 단일 노드 4x GPU 구성

이 수치는 상당한 계산 작업을 신속하게 처리할 수 있는 aiDAPTIV+의 현재 기능 * 을 보여주며 LLM을 효율적이고 저렴하게 미세 조정하려는 중소기업에게 귀중한 자산이 됩니다.

차트에서 GPU만으로는 Llama-2 13b 및 70b 훈련을 완료할 수 없음을 알 수 있습니다. 데이터 세트가 너무 커서 GPU 메모리에만 들어갈 수 없습니다. 이로 인해 훈련이 중단되는 오류가 발생합니다. aiDAPTIV+는 데이터를 조각으로 관리하여 관리 가능한 조각으로 GPU에 공급한 다음 고속 플래시에서 데이터를 다시 컴파일하여 모델을 완성합니다.

*테스트 시스템 사양 – CPU: Intel W5-3435X | 시스템 메모리: 512GB DDR5-4400 Reg ECC | 4x NVIDIA RTX 6000 ADA | 워크로드용 Phison aiDAPTIVCache 2TB SSD 2개

클라우드와 aiDAPTIV+ 기술 비교

기존의 클라우드 기반 AI 교육 솔루션과 비교할 때 aiDAPTIV+는 다음과 같은 몇 가지 주요 영역에서 두드러집니다.

비용 : aiDAPTIV+는 클라우드 서비스와 관련된 높은 비용을 제거하여 훨씬 더 비용 효율적입니다.

데이터 개인정보 보호 : aiDAPTIV+는 온프레미스 교육을 통해 중요한 데이터가 회사 자체 인프라의 안전한 범위 내에 유지되도록 보장하여 중요한 데이터 개인정보 보호 문제를 해결합니다.

소유권 : aiDAPTIV+는 사용자 정의 및 업그레이드를 위한 직접적인 하드웨어 액세스를 통해 완벽한 제어 및 유연성을 제공하여 타사 서비스에 대한 의존도를 줄이고 반복되는 클라우드 비용에 비해 ROI를 향상시킵니다.

이러한 장점으로 인해 aiDAPTIV+는 보다 저렴한 솔루션일 뿐만 아니라 귀중한 데이터를 보호하려는 기업에게 보다 안전하고 신뢰할 수 있는 선택이 됩니다.

aiDAPTIV+는 빠르게 진화하는 AI 및 기계 학습 환경에서 경쟁력을 유지하기 위해 노력하는 중소기업을 위한 중요한 도약을 나타냅니다. LLM 교육을 위한 저렴하고 사용하기 쉽고 효율적인 솔루션을 제공함으로써 aiDAPTIV+는 모든 규모의 기업이 광범위한 리소스나 인프라 없이도 고급 AI 기술을 활용할 수 있도록 지원합니다. aiDAPTIV+를 사용하면 AI의 기능에 그 어느 때보다 쉽게 접근할 수 있으므로 SMB는 서버실에서 편안하게 새로운 기회를 열고 혁신을 주도할 수 있습니다.

현재 지원되는 모델

-

-

- 라마 2 7,13,70B

- 라마 33B

- 비쿠나 33B

- 팔콘 180B

- 코드라마 7B, 34B, 70B

- 속삭임 V2, V3

- 메타포머 m48

- 클립 대형

- 리넷 50, 101

- 디트 베이스

- 미스트랄 7B

- 타이데 7B

-