aiDAPTIV+ が SMB 微調整 LLM の困難にどのように対処するか

aiDAPTIV+ は、高額な価格や複雑さを伴うことなく LLM の力を活用したいと考えている中小企業にとって、ゲームチェンジャーとして登場します。コスト効率、プラグアンドプレイ スタイルの使いやすさ、低消費電力を念頭に設計されたaiDAPTIV+ は、企業がワークステーション クラスのシステムで大規模なモデルを効果的にトレーニングできるようにします。大規模なインフラストラクチャや専門的なトレーニングの必要性がなくなることで、SMB は以前は手の届かなかった AI 主導のソリューションの革新と開発に集中できるようになります。

aiDAPTIV+ の仕組み

aiDAPTIV+ の中核となるのは、極めて耐久性の高い SSD の革新的な aiDAPTIVCache ファミリです。この ai100 SSD は NVMe オフロードを容易にし、わずか 2 ~ 4 個のワークステーション クラスの GPU と標準 DRAM で大規模なモデルの効率的なトレーニングを可能にします。これは、ストレージとコンピューティング リソース間のデータ フローを最適化する aiDAPTIV 管理ソフトウェアによって補完され、パフォーマンスが大幅に向上し、トレーニング時間が短縮され、大規模なモデル トレーニングが可能になります。

標準化された性能

「AI基础建设不能假他人之手。」

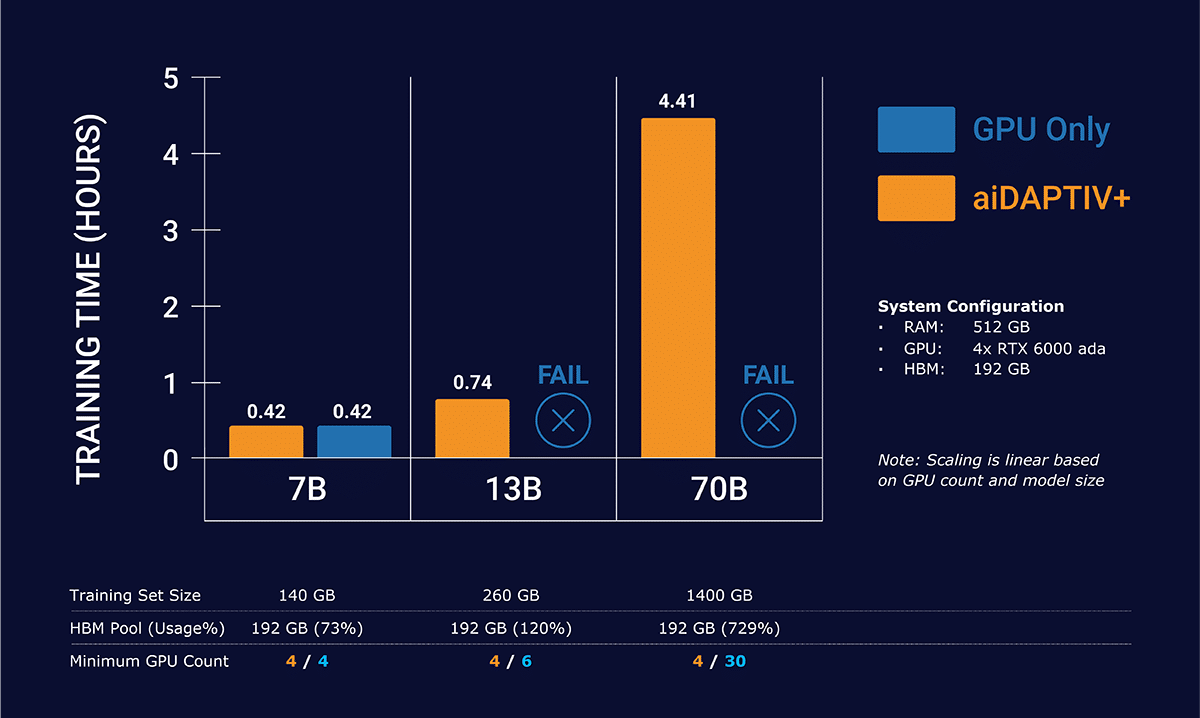

Llama-2 モデルを使用した aiDAPTIV+ のパフォーマンスは、その効率と有効性の証拠です。単一エポックのトレーニング時間は、さまざまなモデル サイズにわたって大幅に短縮されました。

aiDAPTIV+ は線形スケーリングを使用して大規模なモデルをトレーニングします

シングルノード 4x GPU 構成のGPU と GPU + aiDAPTIV+の比較

これらの数字は、大量の計算タスクを迅速に処理する aiDAPTIV+ の現在の能力*を示しており、LLM を効率的かつ手頃な価格で微調整したいと考えている SMB にとって貴重な資産となっています。

このグラフでは、GPU だけでは Llama-2 13b および 70b のトレーニングを完了できないことがわかります。データセットが大きすぎて、GPU メモリのみに収まりません。これにより、トレーニングがクラッシュする障害が発生します。 aiDAPTIV+ はデータをスライスで管理して、管理可能な単位で GPU に供給し、高速フラッシュ上でデータを再コンパイルしてモデルを完成させます。

*テスト システムの仕様– CPU: Intel W5-3435X |システムメモリ: 512GB DDR5-4400 Reg ECC | 4x NVIDIA RTX 6000 ADA |ワークロード用の 2x Phison aiDAPTIVCache 2TB SSD

クラウドと aiDAPTIV+ テクノロジーの比較

従来のクラウドベースの AI トレーニング ソリューションと比較すると、aiDAPTIV+ はいくつかの重要な領域で際立っています。

コスト: aiDAPTIV+ はコスト効率が大幅に向上し、クラウド サービスに関連する高額な費用が不要になります。

データ プライバシー: aiDAPTIV+ は、オンプレミスでのトレーニングを有効にすることで、機密データが企業独自のインフラストラクチャの安全な範囲内に確実に保持されるようにし、重大なデータ プライバシーの懸念に対処します。

所有権: aiDAPTIV+ は完全な制御と柔軟性を提供し、カスタマイズとアップグレードのためのハードウェアへの直接アクセスにより、サードパーティ サービスへの依存を軽減し、繰り返し発生するクラウド コストと比較して ROI を向上させます。

これらの利点により、aiDAPTIV+ は、より手頃な価格のソリューションであるだけでなく、貴重なデータの保護に熱心な企業にとって、より安全で信頼性の高い選択肢になります。

aiDAPTIV+ は、AI と機械学習の急速に進化する状況の中で競争力を維持しようと努めている中小企業にとって、大きな進歩を表します。 aiDAPTIV+ は、LLM をトレーニングするための低コストで使いやすく効率的なソリューションを提供することで、あらゆる規模の企業が大規模なリソースやインフラストラクチャを必要とせずに高度な AI テクノロジーを活用できるようにします。 aiDAPTIV+ により、AI の力がこれまで以上に利用しやすくなり、SMB はサーバー クローゼットの中で新たな機会を開拓し、イノベーションを推進できるようになります。

現在サポートされているモデル

-

-

- ラマ2 7,13,70B

- ラマ33B

- ビクーニャ 33B

- ファルコン180B

- コードラマ 7B、34B、70B

- ウィスパーV2、V3

- メタフォーマー m48

- クリップ大

- レスネット 50、101

- ディートベース

- ミストラル 7B

- タイデ7B

-