Wie aiDAPTIV+ die Schwierigkeiten für KMU bei der Feinabstimmung von LLMs behebt

aiDAPTIV+ erweist sich als Game-Changer für KMUs, die die Leistungsfähigkeit von LLMs ohne den damit verbundenen hohen Preis und die damit verbundene Komplexität nutzen möchten. Bei der Entwicklung von aiDAPTIV+ standen Kosteneffizienz, Plug-and-Play-Benutzerfreundlichkeit und geringer Stromverbrauch im Vordergrund. Damit können Unternehmen größere Modelle effektiv auf Systemen der Workstation-Klasse trainieren. Da keine umfangreiche Infrastruktur oder spezielle Schulung erforderlich ist, können sich KMU nun auf die Innovation und Entwicklung KI-gesteuerter Lösungen konzentrieren, die zuvor unerreichbar waren.

So funktioniert aiDAPTIV+

Das Herzstück von aiDAPTIV+ ist die revolutionäre aiDAPTIVCache-Familie extrem langlebiger SSDs. Diese ai100-SSD erleichtert das NVMe-Offload und ermöglicht das effiziente Training größerer Modelle mit nur 2 bis 4 GPUs der Workstation-Klasse und Standard-DRAM. Ergänzt wird dies durch die Verwaltungssoftware aiDAPTIV, die den Datenfluss zwischen Speicher- und Rechenressourcen optimiert, die Leistung erheblich steigert, die Trainingszeiten verkürzt und ein umfangreiches Modelltraining ermöglicht.

Standardisierte Leistung

„Das einzige wichtige Ereignis im letzten Jahr und die Art und Weise, wie es KI-Forscher hier in dieser Region aktiviert hat, war Lama-2. Es ist ein Open-Source-Modell.“

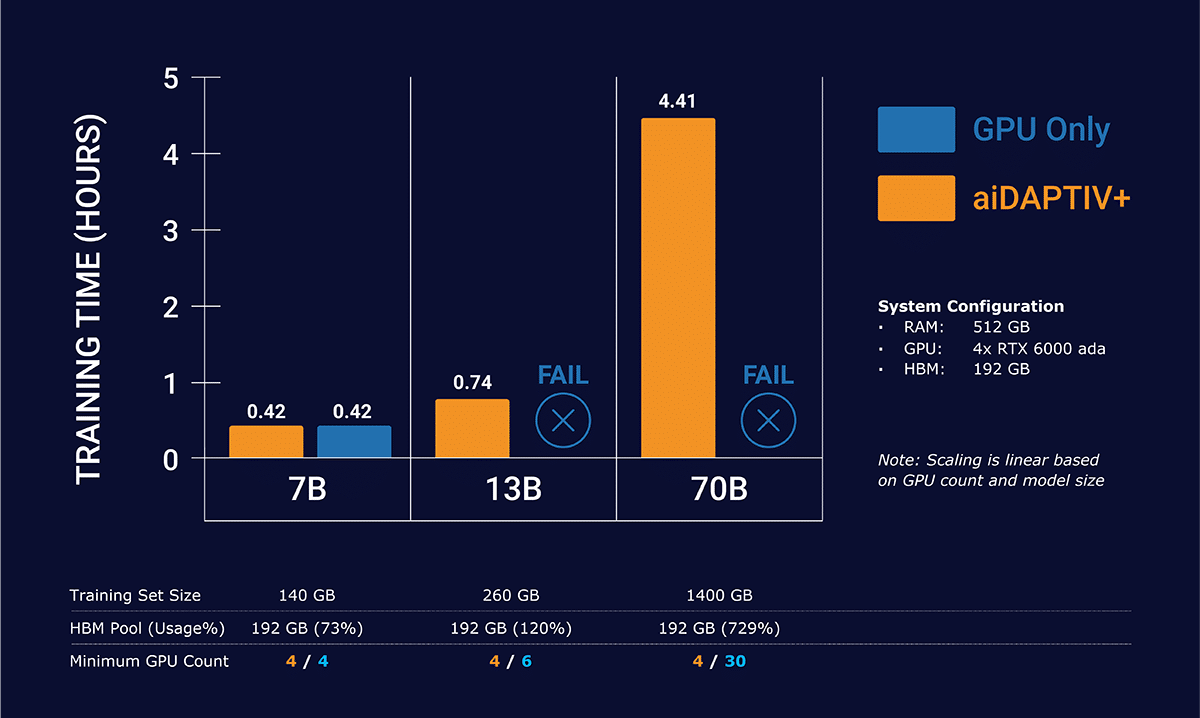

Die Leistung von aiDAPTIV+ mit Llama-2-Modellen ist ein Beweis für seine Effizienz und Effektivität. Die Trainingszeiten für eine einzelne Epoche wurden bei verschiedenen Modellgrößen erheblich verkürzt.

aiDAPTIV+ trainiert größere Modelle mit linearer Skalierung

Einzelknoten-4x-GPU-Konfiguration im Vergleich zwischen GPU und GPU + aiDAPTIV+

Diese Zahlen verdeutlichen die aktuelle Fähigkeit von aiDAPTIV+ * , umfangreiche Rechenaufgaben schnell zu bewältigen, was es zu einem unschätzbaren Vorteil für KMUs macht, die LLMs effizient und kostengünstig optimieren möchten.

Im Diagramm sehen Sie, dass GPUs allein nicht in der Lage sind, das Llama-2 13b- und 70b-Training abzuschließen. Der Datensatz ist zu groß, um allein in den GPU-Speicher zu passen. Dies führt zu einem Fehler, der das Training zum Absturz bringt. aiDAPTIV+ verwaltet die Daten in Slices, um die GPUs in überschaubaren Teilen zu versorgen, und kompiliert die Daten dann auf Hochgeschwindigkeits-Flash neu, um das Modell fertigzustellen.

*Spezifikationen des Testsystems – CPU: Intel W5-3435X | Systemspeicher: 512 GB DDR5-4400 Reg ECC | 4x NVIDIA RTX 6000 ada | 2x Phison aiDAPTIVCache 2 TB SSDs für Workload

Vergleich der Cloud- und aiDAPTIV+-Technologie

Im Vergleich zu herkömmlichen cloudbasierten KI-Trainingslösungen sticht aiDAPTIV+ in mehreren Schlüsselbereichen hervor:

Kosten : aiDAPTIV+ ist deutlich kostengünstiger und eliminiert die hohen Kosten, die mit Cloud-Diensten verbunden sind.

Datenschutz : Durch die Möglichkeit der Schulung vor Ort stellt aiDAPTIV+ sicher, dass sensible Daten innerhalb der sicheren Grenzen der unternehmenseigenen Infrastruktur bleiben, und geht so auf kritische Datenschutzbedenken ein.

Eigentum : aiDAPTIV+ bietet volle Kontrolle und Flexibilität mit direktem Hardwarezugriff für Anpassungen und Upgrades, wodurch die Abhängigkeit von Drittanbieterdiensten verringert und der ROI im Vergleich zu wiederkehrenden Cloud-Kosten verbessert wird.

Diese Vorteile machen aiDAPTIV+ nicht nur zu einer günstigeren Lösung, sondern auch zu einer sichereren und zuverlässigeren Wahl für Unternehmen, denen der Schutz ihrer wertvollen Daten am Herzen liegt.

aiDAPTIV+ stellt einen bedeutenden Fortschritt für KMUs dar, die in der sich schnell entwickelnden Landschaft von KI und maschinellem Lernen wettbewerbsfähig bleiben wollen. Indem aiDAPTIV+ eine kostengünstige, benutzerfreundliche und effiziente Lösung für die Schulung von LLMs bietet, ermöglicht es Unternehmen jeder Größe, fortschrittliche KI-Technologien zu nutzen, ohne dass umfangreiche Ressourcen oder Infrastruktur erforderlich sind. Mit aiDAPTIV+ ist die Leistungsfähigkeit der KI jetzt zugänglicher als je zuvor und ermöglicht es KMUs, neue Möglichkeiten zu erschließen und Innovationen bequem von ihrem Serverschrank aus voranzutreiben.

Derzeit unterstützte Modelle

-

-

- Lama 2 7,13,70B

- Lama 33B

- Vicuña 33B

- Falcon 180B

- CodeLama 7B, 34B, 70B

- Flüstern V2, V3

- Metaformer m48

- Clip groß

- Resnet 50, 101

- Deit-Basis

- Mistral 7B

- TAIDE 7B

-