從一開始,網絡就一直是數據中心的關鍵組成部分。系統如何連接整個企業生態系統的資源對於系統的效率和效果有很大影響。

過去10年左右,企業數據中心隨著雲、邊緣計算、容器化、雲原生計算等多項技術進步而快速發展。為了保持競爭力,組織需要部署智能且靈活的存儲架構,這些架構高度自動化,並且能夠在整個系統中高效、快速地移動數據。

在本文中,我們將探討推動這一快速發展的兩個具體因素。 數據中心存儲的演變 聯網:

計算快速鏈路 (CXL)

CXL 是一種開放標準緩存一致性互連,將內存鏈接到服務器和存儲中的處理任務。它建立在已經很快的 PCI Express (PCIe) 互連之上,該互連已經成為標準一段時間了。

最新的 PCIe 迭代 Gen5 可以以高達每秒 32 千兆傳輸 (GT/s) 的速度連接 CPU 和外設。然而,PCIe 有一些限制,阻礙了當今的數據訪問速度。這些限制之一是它不能非常有效地管理獨立的內存存儲。另一個問題是 PCIe 的延遲太高,無法在多個設備之間有效共享內存。

考慮一下:當今的許多服務器,尤其是超大規模服務器,都包含帶有自己的板載內存的組件。除了連接到主機處理器的主內存之外,還可能有智能網卡、GPU 和存儲 SSD。這些設備的內存緩存通常未得到充分利用,有些甚至利用率很高。這意味著在整個系統中,有大量內存處於閒置狀態。將所有未使用的內存乘以數千台服務器,就會變得非常重要。這些緩存通常無法交互,除非它們有連接它們的工具。

CXL 克服了這些限制。 CXL 的開發部分是為了解決存儲級內存無法充分處理大量處理節點的問題,它利用 PCIe 的物理連接層和電氣配置,但從內存訪問數據時的延遲要低得多。它提供主機服務器和其他設備之間的緩存一致性,因此整個系統的內存被視為單個可訪問池。這些內存池可以顯著增加容量,並可以直接鏈接到 CPU 和 GPU 處理器,以及計算存儲和智能網絡接口卡 (NIC)。

隨著 CXL 兼容系統剛剛開始推出,該技術有可能改變平台和數據中心的設計和運行方式。該行業將逐漸放棄每個節點擁有自己的內存和處理能力的概念,轉而採用分散的基礎設施,從服務於整個生態系統的大型單一內存池中為工作負載分配資源,包括任意數量的GPU、 CPU 和計算存儲。這使得組織能夠構建具有大量內存的數據中心。

CXL 的好處

借助 CXL,組織不再局限於存儲、計算、內存和存儲級內存之間的專有互連,因此多個處理器能夠共享比以前更大的內存池。

CXL 還使組織能夠獲得超越 DRAM 的更大容量和帶寬。使用連接 CXL 的設備,他們可以向 CPU 或 GPU 主機處理器添加內存。這意味著 CPU 和 GPU 可以以 DRAM 的速度訪問 TB 級的存儲空間。

雖然存儲與 DRAM 的延遲實際上沒有可比性(例如,分別為 80 微秒到 0.25 微秒),但仍然沒有真正需要將所有內容都轉移到 DRAM 中。使用 CXL,系統可以通過 CPU 中內置的現有內存層次結構從 SSD 獲取所需的數據,這意味著不需要文件系統和所有伴隨層,這些層可能會增加 10 到 20 微秒的延遲。

當然,文件系統不會很快消失,因為它們對於通用計算具有重要的用途。但通過 CXL,組織可以創建 SSD 存儲數據池,從而以 DRAM 成本的一小部分來增強計算能力。因此,現在,組織不再局限於適合 128 GB DRAM 的數據集,而是可以擁有以 PCIe Gen6 速度運行的數百 TB NVMe SSD 存儲。

CXL 的其他好處包括:

-

-

- 專為內存密集型應用程序設計的開源行業標準

- 支持異構計算並提高本地和雲平台的資源利用率

- 通過跨服務器和應用程序快速、高效地共享數據來增強協作

- 允許團隊在相同的內存數據集上運行並發進程

-

CXL 用例

由於它支持跨整個系統的大型內存池,因此 CXL 非常適合需要大量內存數據的工作負載。這些工作負載包括:

-

-

- 人工智能、機器學習和數據分析 – 深度學習、交互式集成開發環境 (IDE) 培訓

- 在線事務處理(OLTP)和在線分析處理(OLAP)

- 媒體和娛樂 – 圖形模擬、渲染和特效

- 基因研究——測序和組裝分析

- 電子設計自動化 (EDA) 和計算機輔助工程 (CAE) – 建模和仿真

- 金融服務應用程序——支持決策和分析

- 高性能計算——建模和仿真

- 雲 – 內核虛擬機 (KVM) 的快照、非容錯工作負載的臨時實例

-

超大規模企業和雲服務提供商可能會傾向於 CXL,因為它具有超快的擴展和配置功能。

NVMe over Fabric (NVMe-oF)

隨著時間的推移,存儲區域網絡 (SAN) 的傳輸協議已經發生了顯著的發展。人們開發了不同的協議來連接基於 HDD 的 SAN,例如 iSCSI、串行連接 SCSI (SAS) 和光纖通道協議 (FCP)。這些協議為 HDD 提供了足夠的性能,但對於 SSD 來說還不夠。當HDD更換為SSD,HDD瓶頸被消除後,協議本身就成為了瓶頸。基於 NAND 閃存的存儲需要更多的東西來幫助組織獲得該技術的所有優勢。

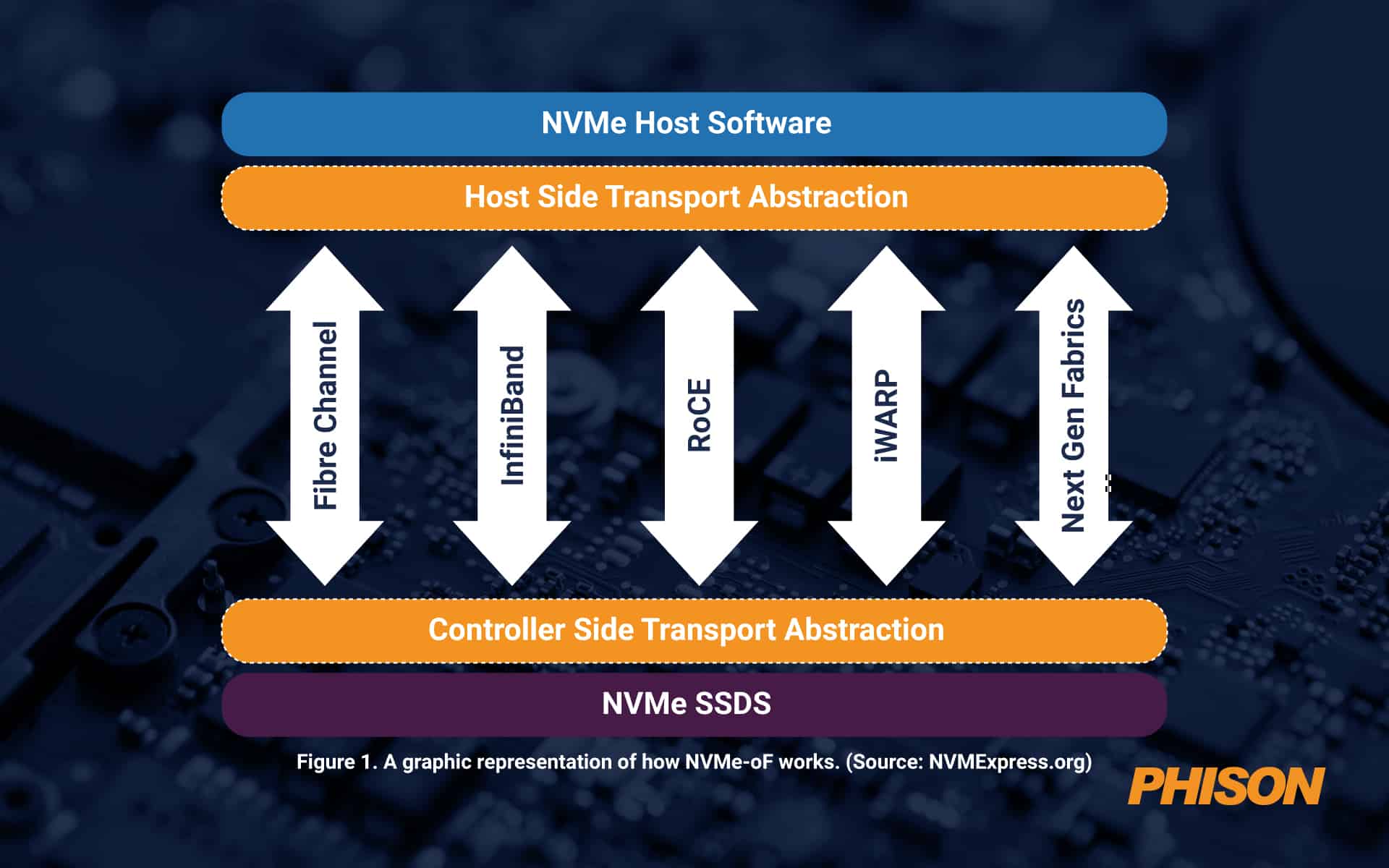

隨著數據池規模越來越大,它們並不總是通過 PCIe 結構進行連接,而 PCIe 結構對大約 100 英尺的物理距離有效。除此之外,還需要其他東西。這就是 NVMe over Fabrics (NVMe-oF) 的用武之地。該協議充當消息傳遞層,支持主機服務器和固態存儲或其他設備之間或通過擴展網絡(也稱為結構)之間的數據傳輸。

NVMe-oF 非常適合使用閃存或其他 SSD 存儲的塊存儲。它提供低延遲和高性能,以及簡單的可擴展性,並支持四種主要網絡協議,即光纖通道、iWARP、InfiniBand、RDMA、RoCE(融合以太網上的 RDMA)和 TCP/IP。 NVMe-oF 比網絡附加存儲 (NAS) 更好,因為它的開銷要少得多。如今,一旦距離對於 PCIe 來說太大,從延遲的角度來看,它已經是最好的了。

圖 1. NVMe-oF 工作原理的圖形表示。 (來源: NVMExpress.org)

NVMe-oF 的優勢

NVMe-oF 能夠創建類似於直連存儲 (DAS) 的低延遲高性能存儲網絡。這意味著整個系統的服務器可以根據需要共享閃存設備。從本質上講,組織可以獲得基於閃存的陣列的快速性能以及共享或網絡存儲的優勢。

使用 NVMe-oF,組織可以創建一個與服務器分離並作為單個共享池進行管理的存儲系統。這意味著 IT 可以比以往更精細、更靈活地配置存儲資源。

其他好處包括:

-

-

- 超低延遲

- 服務器應用程序和存儲之間的連接速度更快

- 更高效的 CPU 使用率

- 更高的利用率

- 管理更輕鬆

- 提高整體性能

- 額外的並行請求

- 提高冗餘度和彈性

-

NVMe-oF 用例

NVMe-oF 協議非常適合涉及通過網絡將數據從存儲移動到任何閃存介質的任何用例。如今,許多組織在高性能至關重要的情況下使用 NVMe-oF,例如人工智能或機器學習、數據分析和高性能計算。它還非常適合事務性工作負載。

群聯提供尖端 SSD 以滿足當今的高級需求

隨著數據傳輸速度的提高, 群聯 可以為客戶提供 PCIe Gen5 SSD平台定制 在他們的應用程序中發揮最佳性能。事實上,Phison最近發布了業界首款Gen5 SSD之一, 群聯E26,可為當今的大型複雜工作負載提供業界最快的速度。

此外,群聯持續大力投資研發,打造符合新興技術的 SSD 解決方案,確保其產品面向未來並準備好為未來的創新提供動力。