Heutzutage werden mehr Daten erstellt, verarbeitet und gespeichert, als wir uns jemals vorstellen können. Software, Algorithmen, IoT-Geräte und andere Maschinen haben sich den Menschen angeschlossen, die Daten generieren – in unterschiedlichen Formen, mit unterschiedlichen Methoden und für unterschiedliche Zwecke. Laut Angaben wurden im Jahr 2020 über 64 ZB an Daten erstellt ein IDC-Bericht.

Durch die intelligente und zeitnahe Nutzung von Daten erhalten Sie Erkenntnisse, die einen unglaublichen Mehrwert schaffen und die Effizienz Ihres Unternehmens steigern. Diese Effizienzsteigerungen erfordern jedoch schnellere, leistungsstarke und zuverlässige Arbeitsspeicher-, Rechen- und Speicherressourcen als je zuvor, um den Anforderungen geschäftskritischer Arbeitslasten gerecht zu werden. Und es geht nicht nur um eins über das andere – sowohl Speicher als auch Datenspeicher müssen sich weiterentwickeln, integrieren und zusammenlaufen, wenn die Komplexität und Herausforderungen des heutigen Streamings, mehrdimensionaler Datensätze und Echtzeitanalysen gemeistert werden sollen.

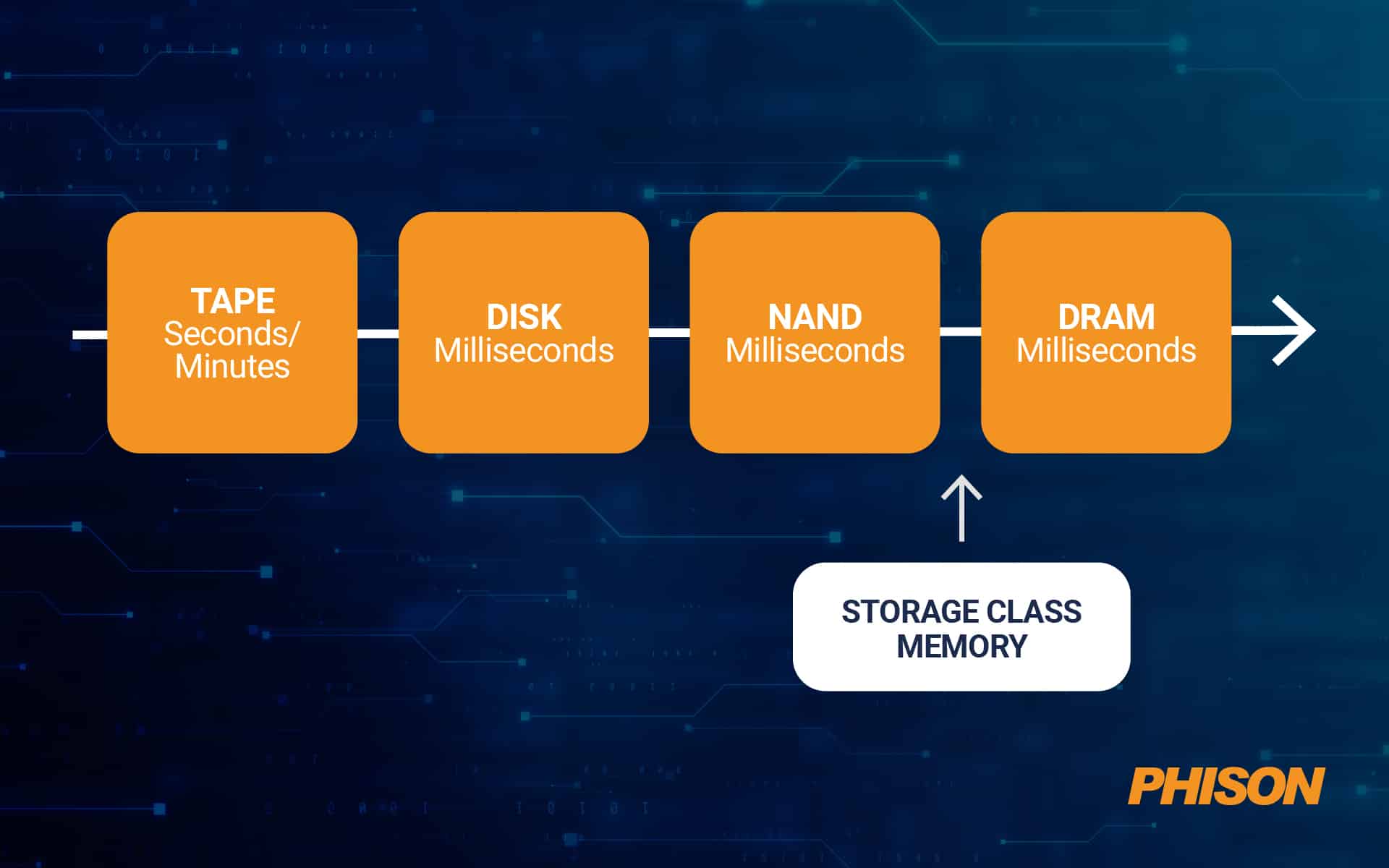

Die Arbeitsspeicher-/Speichertrennung entstand aus einem Kompromiss zwischen Geschwindigkeit und Beständigkeit (IDC schätzt, dass selbst heute nur 2% der 64 ZB gespeichert werden). Allerdings verschwimmen die Grenzen zwischen Erinnerung und Speicherung zunehmend bahnbrechende Entwicklungen bei Technologien, die die Speicherübertragungsgeschwindigkeit verbessern. Storage Class Memory (SCM) ist beispielsweise eine Form des persistenten Speichers, der als eine Art Brücke zwischen NAND-Flash und DRAM fungiert, indem er nichtflüchtigen Speicher ähnlich wie DRAM speichert. Und das mit der zehnfachen Geschwindigkeit von NAND-Flash-Laufwerken und den halben Kosten von DDR-SDRAM.

Quelle: Pure Lagerung

Dies ermöglicht komplexe Datenbank-, Analyse-, Dateispeicher- und Online-Transaktionsverarbeitungs-Workloads (OLTP) über verschiedene Anwendungsfälle hinweg, indem die Latenz reduziert und eine leistungsstarke Speicherung unstrukturierter Datensätze ermöglicht wird.

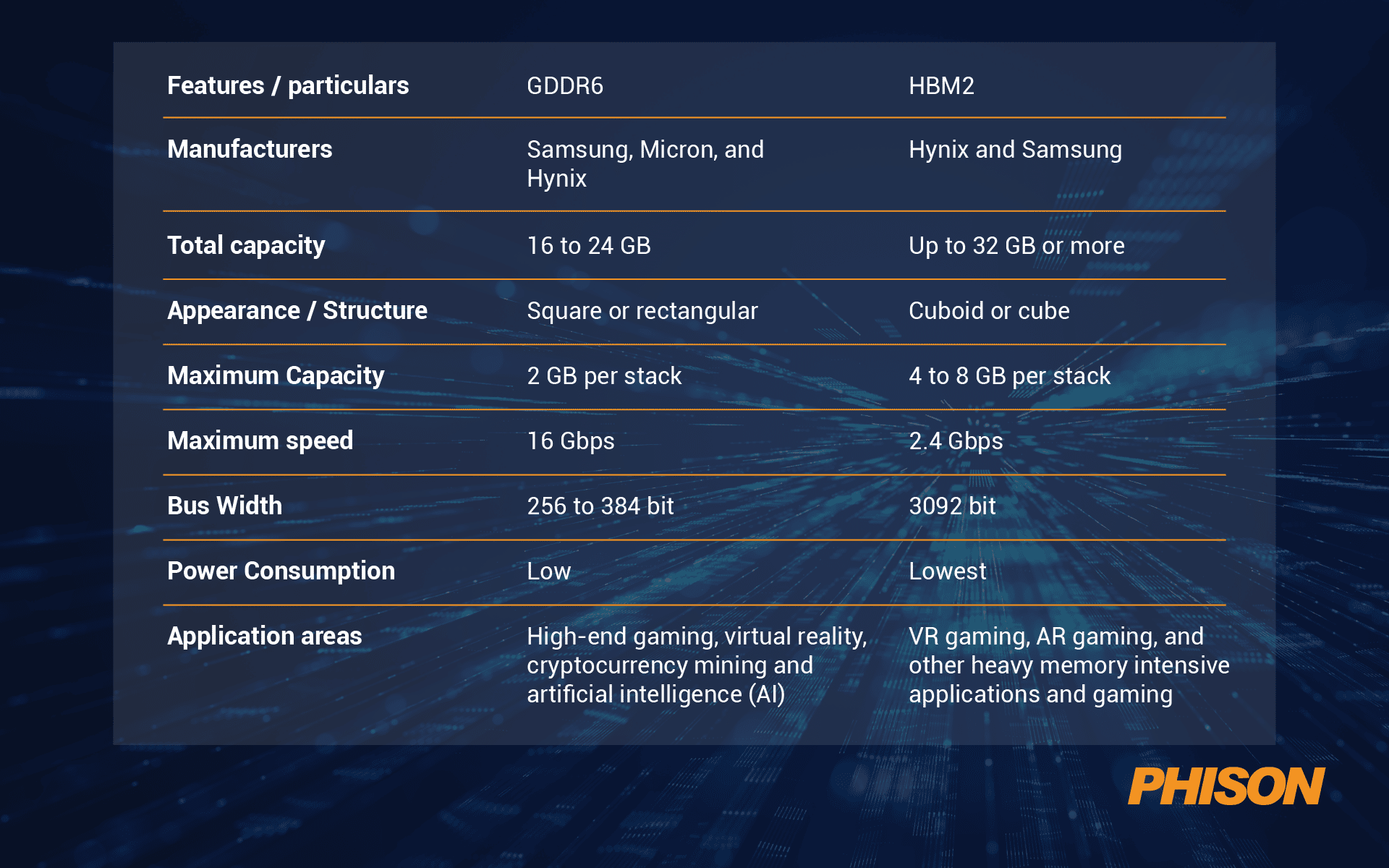

Genauer gesagt gibt es Hochleistungsspeicher in zwei Varianten:

-

-

- Graphic Double Data Rate (GDDR) – ein kostenoptimierter Hochgeschwindigkeitsstandard mit Anwendungen in den Bereichen KI und Kryptowährungs-Mining

- High-Bandwidth Memory (HBM) – ein energieeffizienter Standard mit hoher Kapazität für Anwendungen in AR/VR, Spielen und anderen speicherintensiven Arbeitslasten

-

Quelle: Gesicht davon

Im Speicherbereich werden schnelle SSDs aufgrund ihrer geringen Latenz und ihres hohen Durchsatzes zunehmend zum Kern von Speichersystemen in High-Performance-Computing- (HPC) und hyperkonvergenten Infrastrukturarchitekturen (HCI).

SSDs mit Phisons E18 NVMe-Controllern, die auf der PCIe Gen 4.0-Schnittstelle laufen, bringen Systeme mit bisher unerreichten Geschwindigkeiten von 7,4/7,0 GB pro Sekunde für sequentielle Lese- und Schreibvorgänge in Aufruhr. Phison soll ebenfalls ausgeliefert werden benutzerdefinierte PCIe Gen 5.0 SSDs später in diesem Jahr für Erstanwender des Standards.

Sehen wir uns an, wie unterschiedliche Branchen – von Biowissenschaften bis Telekommunikation, von Fertigung bis Fintech – die richtige Mischung aus Hochleistungsspeicher und Speicher nutzen, um ihre Geschäftsfunktionen voranzutreiben.

Künstliche Intelligenz (KI) und maschinelles Lernen (ML)

KI-basierte Algorithmen sind in nahezu jeder Branche angekommen. Deep Learning und ML treiben die Datenerfassung und -verarbeitung in der medizinischen Behandlung, Kreditauszahlung, Gaming, Personalbeschaffung und fast jeder erdenklichen Geschäftsfunktion voran. KI ist eine prozessor- und speicherintensive Technologie, die in vielen groß angelegten Implementierungen GPUs erfordert (die bei der Ausführung komplexer mathematischer und statistischer Berechnungen effizienter sind als CPUs).

GPUs wiederum benötigen Hochleistungsspeicher für die „Trainings“- und „Inferenz“-Operationen des ML-Algorithmus.

Sie benötigen große Datensätze, um den Algorithmus oder das neuronale Netzwerk so zu trainieren, dass es seine Aufgabe gut „lernen“ kann. Häufig sind diese Datensätze so groß, dass sie auf mehrere Server oder Cloud-Systeme aufgeteilt, parallel ausgeführt oder über mehrere Tage hinweg in das System eingespeist werden müssen. Dies bedeutet, dass der Speicher einen Engpass für die „Einspeisung“ (oder Aufnahme) der Daten in die Algorithmen darstellt. Sie benötigen energieeffizienten Speicher mit hoher Bandbreite und hoher Kapazität sowie große, schnelle Speicherlösungen.

Bevor der Aufnahmeprozess beginnt, müssen Daten aus verschiedenen Quellen gesammelt werden. Da diese Daten unstrukturiert oder in verschiedenen Formaten vorliegen können, die miteinander nicht kompatibel sind, müssen sie in ein einziges akzeptables Format umgewandelt werden. Die Geschwindigkeit der Transformation hängt wiederum von der Qualität (und Quantität) des installierten Speichers und Speichers ab. Im Gegensatz zum Aufnahmeprozess ist der Speicherzugriff während der Transformation unterschiedlich und erfordert sowohl sequentielle als auch zufällige Lese- und Schreibvorgänge.

Dieses Problem wird mit NVMe-SSDs gelöst – sie ermöglichen Ihnen die Erstellung und Verwaltung größerer Datensätze, indem sie den Speicherteil durch dynamische Bereitstellung von den Rechenknoten trennen. NVMe-Controller ermöglichen außerdem den parallelen Zugriff zwischen der GPU und den Speichermedien, wodurch die Epochenzeit des ML-Modells (oder die Zeit, die für einen vollständigen Durchlauf des gesamten Datensatzes benötigt wird) beschleunigt und die GPU-Auslastung maximiert wird.

Nachdem das KI-Modell trainiert wurde, beginnt die Inferenzphase – hier präsentiert der Algorithmus seine Ergebnisse und hilft bei der Entscheidungsfindung. KI/ML-Inferenz erfordert Speicher mit hoher Bandbreite und geringer Latenz, um Antworten in Echtzeit zu liefern. Hier gewinnen Schnelligkeit und Reaktionszeit an Bedeutung.

Hochauflösendes Streaming-Video (Medien und Unterhaltung)

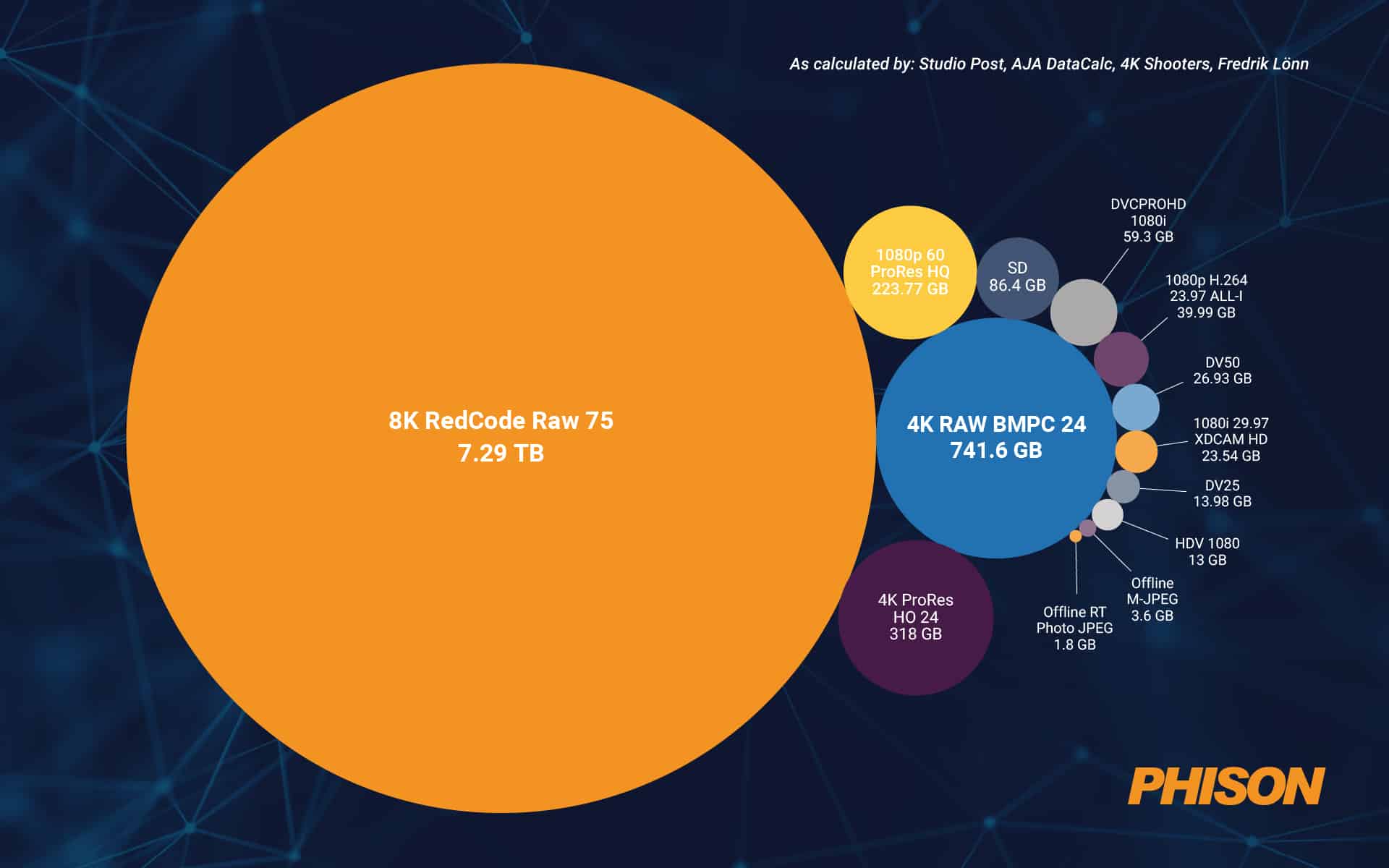

Video ist der Elefant im Raum, wenn es um Dateigröße und Datenvolumenwachstum geht. Während bessere Auflösungen das Zuschauererlebnis verbessern, erhöhen sie die Menge der über Netzwerke gespeicherten und übertragenen Daten erheblich. Das Streamen von HD-Videos (1080p) über YouTube oder Netflix „kostet“ 1,6 GB und 3 GB pro Stunde der Daten bzw. Wenn Sie die Auflösung auf 4K erhöhen, steigt der Verbrauch auf 2,7 GB bzw. 7 GB pro Stunde. Die Akzeptanz und Verfügbarkeit von 4K-Inhalten nimmt an Fahrt auf, da öffentlich-rechtliche Rundfunkanstalten und OTT-Anbieter ihre Nutzung bei der Programmierung und Verbreitung verstärken.

Quelle: Signifikant

Während die Speicherung von Videos und Medien für Infotainment heutzutage größtenteils das Anliegen von Cloud-Dateispeicheranbietern ist (dank der Verfügbarkeit schneller Verbindungen mit hoher Bandbreite), sind Verbraucher und Unternehmen auf der Suche nach SSDs mit größerer Kapazität leseintensive Arbeitslasten sollte sich der Kompromisse bewusst sein. Die meisten dieser SSDs sind mit gebaut QLC NAND-Flash Chips und haben tendenziell eine höhere Latenz, eine geringere Ausdauer und eine geringere Leistung als ihre TLC-Gegenstücke.

Spielen

Medien und Unterhaltung sind nicht die einzige Branche, die die Einführung von 4K/8K-Videos beschleunigt. High-End-Gaming erfordert neben hochauflösenden Grafiken auch schnellere Reaktionszeiten ohne Verzögerungen oder Pufferung. Es ist bekannt, dass Gaming-Enthusiasten und Profis häufig mehrere Monitore mit 4K-/8K-Bildschirmen verwenden, die leistungsstarke Grafikkarten und große Framebuffer benötigen. HBM ermöglicht eine Bildpuffergröße von 16 bis 32 GB bei einer Rate von 4096 I/O pro Sekunde.

Während 4K-Grafik heute der Standard für Gaming-Rechner ist, ist 8K eindeutig die Zukunft. Dies erfordert größere und schnellere konsoleninterne und externe SSDs, um Videos mit hoher Geschwindigkeit zu speichern und zu lesen/schreiben.

Es ist kein Geheimnis, dass moderne Videospiele die größten Verbraucher von DDR-RAM sind. Mit der Verbreitung von Cloud-Gaming, das von Rechenzentren voller GPUs betrieben wird, die eine realistische Wiedergabe ermöglichen, steigen die Speicheranforderungen sowohl für PC- als auch für Konsolenspiele immer weiter.

Professionelles PC-Gaming erfordert oft ultrahochauflösende 4K/8K-Grafiken, bei denen die GPU komplexe Vorgänge wie Raytracing und Variable-Rate-Shading ausführt. Diese Operationen erfordern eine Null-Latenz. Verzögerungen und Pufferung sind ein Verbrechen, das kein ernsthafter Spieler verzeihen wird, weshalb GDDR- oder HBM-Speicher eine nicht verhandelbare Voraussetzung sind.

Dann ist da noch die Frage der Lagerung. Das durchschnittliche AAA-Spiel mit 2K-Auflösung belegt etwa 50 GB Speicherplatz auf der Festplatte. Da 4K-Auflösungen zur Norm werden, beanspruchen Mainstream-Spiele, die hochauflösende, einzigartige Textur-Mapping- und fotorealistische 3D-Rendering-Assets verwenden, problemlos 150 bis 200 GB Speicherplatz. Das bedeutet, dass für die Verwaltung einer Standardsammlung von etwa 20 Spielen sowie Mods, Extra-Packs und anderen herunterladbaren Inhalten (DLC) mindestens 2 TB Speicherplatz auf der internen SSD erforderlich sind.

Gaming-SSDs müssen neben großer Kapazität auch Lesegeschwindigkeiten von mehr als 5,5 GB/s aufweisen, da sonst Texturen und Objekte in der Nähe Ihrer Charaktere mit Verzögerung erscheinen. Moderne PCIe Gen4 NVMe M.2-Laufwerke können Lesegeschwindigkeiten von bis zu 7 GB/s für große, zusammenhängende Dateien und 3 GB/s für kleinere, verstreute Dateien erreichen.

Augmented Reality (AR) und Virtual Reality (VR)

AR und VR haben sich langsam, aber stetig in verschiedenen Branchen durchgesetzt – Spiele, Gesundheitswesen, Ingenieurwesen, Architektur, Bauwesen, Bildung und mehr. Sie werden nicht nur in realen Anwendungen eingesetzt, sondern auch häufiger in Schulungen und Simulationen eingesetzt. Virtuelle Objekte können auf reale Objekte übertragen werden, um zu verstehen, wie sie sich nach dem Bau oder der Installation verhalten könnten.

High-End-AR und VR-Headsets die für geschäftskritische Anwendungen eingesetzt werden, benötigen Ultra-High-Definition-Displays (UHD) mit einer Auflösung von 3840×2160. Diese erfordern leistungsstarke Grafikkarten mit leistungsstarkem Speicher. Ein Standardbild mit 4K-Auflösung ist 33,2 MB groß, vorausgesetzt, es ist mit 32-Bit-RGB kodiert. Ein 4K-VR-Display mit einer Bildrate von 90 FPS erfordert für bewegte Standardbilder eine Datenübertragungsrate von 3 GB/s – das bedeutet eine Lesegeschwindigkeit von 6 GB/s auf der SSD für ein Paar Bilder. Detailliertere Bilder erfordern eine Bandbreite von bis zu 10 GB/s, was für die heute auf dem Markt erhältlichen SSDs unerreichbar ist. (Die E26-SSD von Phison, deren Veröffentlichung für Ende 2022 geplant ist, wird diese Lese-/Schreibgeschwindigkeiten erreichen und sogar übertreffen.)

Hochleistungsrechnen (HPC)

Heutzutage gibt es in vielen Bereichen spezifische, spezialisierte Geschäftsfunktionen, die einen sehr hohen Bedarf an Rechenleistung, Speicher und Bandbreite haben. Viele Aufgaben in der wissenschaftlichen Forschung, im Finanzwesen, in der Fertigung, im Verteidigungs-, Energie- und Gesundheitswesen erfordern die Erfassung und Verarbeitung großer Datenmengen mit modernster Leistung.

Spieleentwicklung, Videobearbeitung, VR-Simulation und CAD sind nur einige der mittelgroßen Arbeitslasten, die erhebliche I/O-Ressourcen und Bandbreite beanspruchen. Diese benötigen leistungsstarke Computing- und Cloud-Systeme, die zusammen HPC bilden. Beim HPC handelt es sich um Supercomputer, die das Wetter vorhersagen, Derivatepreise ermitteln und Satelliten steuern – diese benötigen viel mehr Speicherplatz, Speicher und Bandbreite als der Durchschnitt. HPC ist heute ein zentraler Bestandteil betrieblicher Arbeitsabläufe und nicht nur eine IT-Kostenstelle. Es erfordert eine zuverlässige, flexible, skalierbare und effiziente Speicherinfrastruktur.

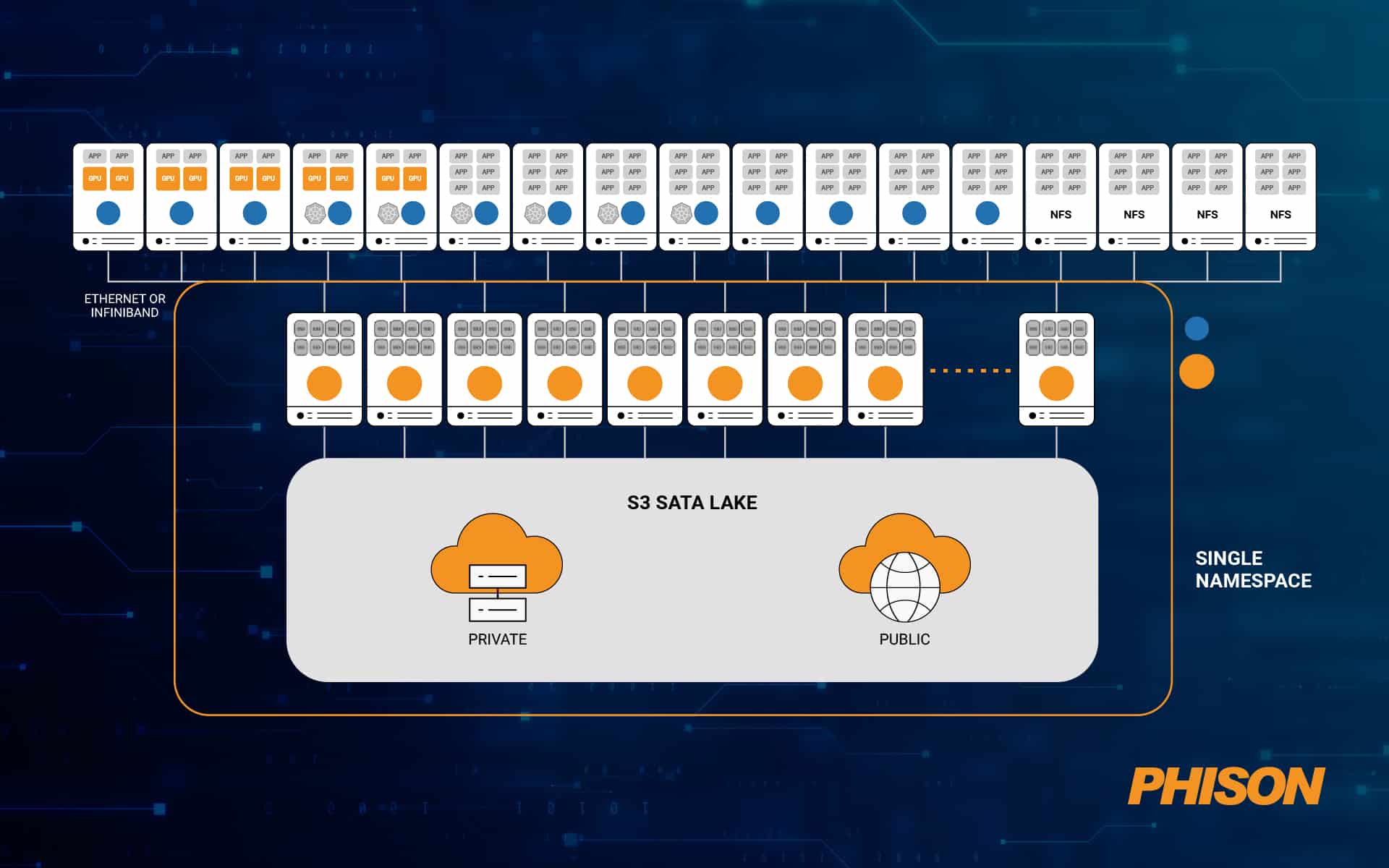

Eine typische Anwendung, die auf HPC läuft – etwa eine Flugsimulation oder eine molekulare Interaktionssimulation – würde riesige Datenmengen benötigen, um sie zu laden und zu starten. In Kombination mit Benutzerinteraktionen in Echtzeit erfordert dies eine Speicherinfrastruktur mit geringer Latenz, hoher Bandbreite und extremer Kapazität. In einem HPC-Cluster kann die Datenmenge, die auf Speichergeräten gelesen/geschrieben wird, in der Größenordnung von Exabyte (EB) liegen. Aus diesem Grund muss die Datenverarbeitung für die Speicherung von der CPU entlastet werden, um eine Unterbrechung der Rechenvorgänge zu vermeiden.

Darüber hinaus verfügen HPC-Anwendungen über zwei Arten von Daten – „heiße“ Daten, auf die häufig zugegriffen wird (und die daher auf SSDs in der Nähe der Rechenknoten gespeichert werden müssen) und „kalte“ Daten, auf die selten zugegriffen wird (und die sich daher darauf befinden können). Speicherarrays).

Heutige Speicherlaufwerke verwenden ein paralleles Dateisystem (PFS), sodass jeder Knoten im Cluster mit minimalen Wartezeiten parallel mit jedem Laufwerk kommunizieren kann. Nur die neuesten SSDs mit NVMe-Controller sind in der Lage, alle Anwendungsanfragen ohne Verzögerung zu bearbeiten.

Quelle: WEKA

Automobil

Die Zukunft der Automobilindustrie ist FALL – Vernetzt, autonom, geteilt, elektrisch. Jede dieser Eigenschaften und Funktionen stellt an moderne Autos hohe Anforderungen an die Datenerfassung, -verarbeitung und -speicherung. Herkömmliche Autos werden heute bereits genauso stark mit Daten betrieben wie mit Kraftstoff – jedes Auto erzeugt Daten mehr als 1 TB Daten pro Tag:

-

-

- Telematik- und V2X-Anwendungen – 8 GB bis 64 GB

- Infotainment – 64 GB bis 256 GB

- HD-Mapping – 16 GB bis 128 GB

- Armaturenbrettkamera – 8 GB bis 64 GB

- Digitales Kombiinstrument – 8 GB bis 64 GB

- Mensch-Maschine-Schnittstelle (HMI) – 32 GB bis 64 GB

- Augmented Reality (AR) – 16 GB bis 128 GB

- Advanced Driver Assistance System (ADAS) – 8 GB bis 128 GB

- Unfallaufzeichnung – 8 GB bis 256 GB

-

In weniger als einem Jahrzehnt werden wir 90 Millionen vernetzte autonome Fahrzeuge (AVs) haben, die zusammen 1 ZB an Daten pro Tag erzeugen werden. Wie können wir diese enormen Datenmengen sinnvoll nutzen – geschweige denn verwalten? Die Antwort ist NAND-Flash-basiert Aufbewahrungslösungen für die Automobilindustrie wie eMMC, SSD und UFS die synchron mit einer zentralen Cloud und KI-basierten Anwendungen arbeiten.

Beschleunigung der Innovation mit Phison

Phison ist ein Marktführer für NAND-Flash-Controller und Speicherlösungen – die Grundlage für jede einzelne der realen Anwendungen, die wir heute besprochen haben. Es bietet Kunden, Unternehmen Und eingebettet Lösungen, die die Grenzen von Geschwindigkeit, Kapazität, Zuverlässigkeit und Effizienz im Speicher und Datenspeicher erweitern.

Die erstklassigen SSD-Produkte von Phison werden nach kundenspezifischen Spezifikationen für Leistung, Leistung und Ausdauer hergestellt und optimiert, sodass sie für die komplexesten, datenintensivsten und geschäftskritischsten Anwendungen in jeder Branche geeignet sind. Sie bieten eine konsistente Leistung und schnellere Reaktionszeiten und verbessern so direkt die Erfolgsquote geschäftlicher Workloads.