了解为什么高性能存储对于获得最有效的实时 AI 洞察至关重要,以及群联电子如何让这一切变得轻松。.

人工智能正在改变组织机构与其数据交互的方式。但下一个重大飞跃不仅仅在于模型开发,更在于这些模型如何按需访问、检索和综合信息。而这正是检索增强生成(RAG)的用武之地。.

RAG 将传统生成式 AI 与从外部数据源实时检索相关上下文的能力相结合。这种混合方法能够提供更准确、更及时、更具上下文感知的响应,使其成为企业搜索、对话式 AI、客户支持和科学研究等应用的理想选择。然而,RAG 要大规模地发挥真正的价值,需要的不仅仅是智能模型,还需要卓越的存储性能来支持对大型非结构化数据集的快速、无缝访问。.

RAG为何如此要求苛刻?

与仅基于预训练参数的传统生成模型不同,RAG 将外部知识注入到推理过程中。当收到用户查询时,系统首先从知识库中检索相关文档,然后将查询和检索到的数据都输入到 RAG 中。 大型语言模型(LLM) 生成响应。.

这一两步流程意味着模型必须与海量且通常异构的数据集进行交互,这些数据集涵盖了从内部维基和支持日志到学术期刊和交易记录等各种类型。这些数据集需要以支持以下操作的方式存储:

-

-

- 低延迟检索相关内容

- 用于推理流水线的高通量处理

- 快速更新和索引,以适应不断变化的数据源

- 可扩展性,以适应不断增长的人工智能知识库

-

传统存储方式已无法满足需求。硬盘会造成性能瓶颈。传统固态硬盘虽然读取速度尚可,但在扩展至 GPU 驱动的 AI 集群时,其耐用性和吞吐量可能不足。RAG 工作负载需要更快、更智能、更具弹性的解决方案。.

SSD在加速AI和RAG工作流程中的作用

存储是现代人工智能背后的隐形引擎。而对于资源分配全局模型(RAG)而言,卓越的存储性能至关重要。.

高性能 NVMe SSD 可提供 RAG 流水线所依赖的超低延迟和高每秒输入/输出操作数 (IOPS)。它们能够实现:

-

-

- 利用 FAISS 或 Vespa 等相似性搜索库,在大规模嵌入中快速进行向量搜索

- AI工作流程中的快速预处理和后处理阶段

- 无缝并行处理,多个GPU可以同时处理大量数据而不会发生I/O争用。

- 最小推理延迟对于面向客户或实时人工智能应用至关重要

-

下一代 SSD 利用 PCIe Gen5 接口进一步改进了这一点,每通道带宽高达 60 GB/s,足以满足高吞吐量 AI 系统的需求,并能全速为 GPU 提供数据。.

为什么以数据为中心的架构在 RAG 中至关重要

人工智能处理已从以计算为中心转向以数据为中心。在 RAG 流水线中,性能瓶颈通常不在于模型本身,而在于数据流的速度和智能程度。这包括:

-

-

- 数据摄取——新数据被索引和检索的速度。

- 访问速度——推理过程中获取相关上下文的速度

- 生命周期管理——数据集在热存储层、温存储层和冷存储层之间移动的效率

-

正因如此,新一代固态硬盘,尤其是专为人工智能应用场景设计的固态硬盘,才显得不可或缺。它们不仅提供极快的速度,还具备卓越的耐用性、智能缓存以及稳定处理混合工作负载的能力。.

群联电子如何帮助您快速、大规模地构建人工智能

在打造更智能、更快速、更值得信赖的人工智能的竞赛中,关键不仅仅在于模型权重和训练数据,更在于你的基础设施能否在恰当的时间为这些模型提供恰当的信息。RAG 正在引领人工智能向更具情境感知能力的方向发展,但要使其大规模应用,你需要一个能够与你的机器思维速度相匹配的存储层。.

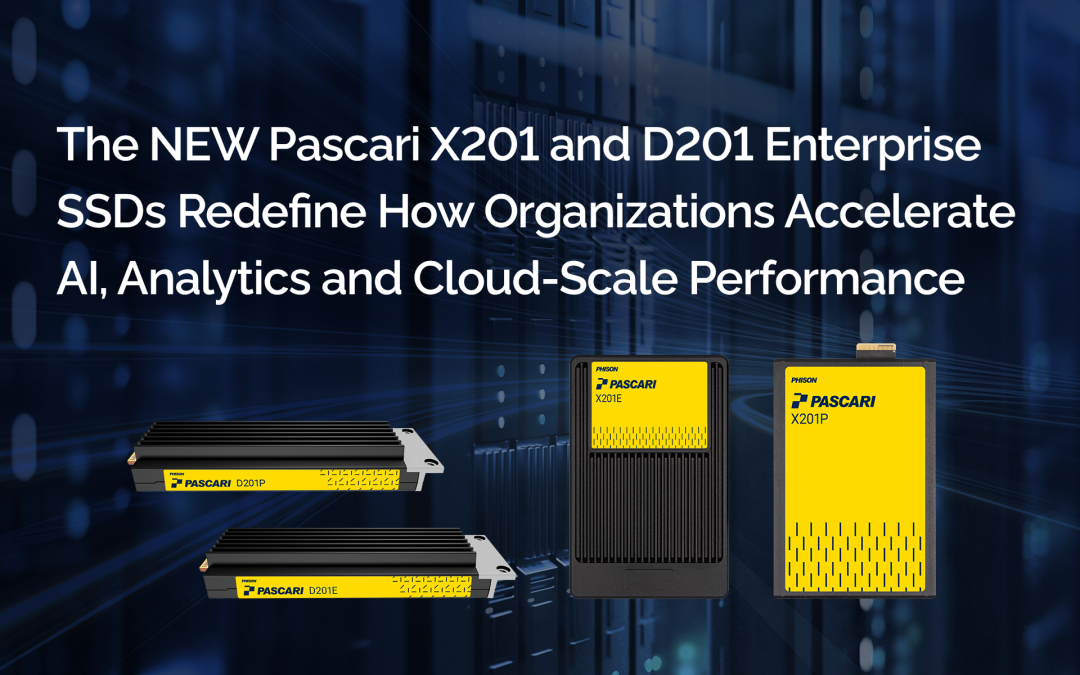

群联电子的下一代固态硬盘产品组合专为满足人工智能和RAG工作流程不断变化的需求而设计。这些固态硬盘具备低延迟、高耐用性和针对人工智能优化的吞吐量,能够帮助企业最大限度地发挥其人工智能基础设施的性能,无论是在本地、混合云还是边缘。.

群联电子还提供端到端的AI存储架构支持,帮助企业:

-

-

- 设计适用于LLM和RAG管道的高性能存储堆

- 实施智能分层以平衡速度和成本

- 启用数据本地化策略以降低延迟和网络依赖性

- 采用支持 PCIe Gen5 的设备和高级固件调优,打造面向未来的基础设施

-

利用群联电子人工智能优化持久存储的组织 Pascari 企业级 SSD 和 aiDAPTIV+ 缓存内存 SSD 更快地获得洞察,更流畅地部署模型,并更敏捷地响应不断变化的数据需求。具备当今所需的速度、弹性和智能。

在最先进的人工智能架构方面,群联电子不仅跟上了创新的步伐,而且还在引领创新。.

常见问题 (FAQ):

Phison参与AI基础设施技术实践日的重点是什么?

群联科技重点关注机构在本地部署人工智能推理和模型训练时面临的实际挑战。会议讨论了GPU内存限制、基础设施成本障碍以及在本地运行大型语言模型的复杂性。群联科技还介绍了 爱达普替夫 作为控制器级解决方案,旨在简化 AI 部署,同时减少对高成本 GPU 内存的依赖。.

TechStrong TV 的“导演精选”网络研讨会是什么?

TechStrong TV 精心剪辑了 Phison 技术日活动的精彩片段,并以“技术日内幕”网络研讨会的形式呈现。这种形式提炼了最具价值的技术见解,并包含专家小组的评论,使 IT 和研发领导者无需观看完整会议即可轻松掌握架构方面的关键信息。.

本次网络研讨会邀请了哪些 Phison 的演讲嘉宾?

本次网络研讨会重点介绍了群联电子的两位技术领导者:

- 布莱恩·考克斯, 解决方案和产品营销总监,负责经济实惠的本地 LLM 培训和推理。.

- 塞巴斯蒂安·让, 首席技术官,他解释了使用 aiDAPTIV 进行 LLM 微调和推理的 GPU 内存卸载技术。.

为什么本地部署的人工智能对大学和研究机构如此重要?

本地部署的人工智能使机构能够维护数据主权、满足合规性要求并保护敏感的研究数据。它还能降低长期云成本,并为用于研究、教学和内部运营的人工智能工作负载提供可预测的性能。.

本次网络研讨会主要讨论了哪些基础设施挑战?

主要挑战包括GPU内存容量有限、基础设施成本不断攀升以及本地部署和管理LLM的复杂性。这些限制往往阻碍机构将人工智能项目从试点项目扩展到更广泛的应用。.

Phison aiDAPTIV 如何实现经济实惠的本地 AI 训练和推理?

Phison aiDAPTIV 在控制器层面使用高性能 NVMe 存储扩展 GPU 内存。这使得大型模型能够在现有硬件上运行,而无需额外的 GPU 或专门的编码,从而显著降低了本地 AI 部署的成本门槛。.

“GPU内存卸载”在实际应用中意味着什么?

GPU内存卸载功能允许AI工作负载在GPU内存饱和时透明地使用NVMe存储。对于研究人员和IT团队而言,这意味着无需重新设计流程或重写代码即可训练或微调更大的模型。.

aidDAPTIV 是否需要对现有的 AI 框架或代码进行更改?

不。aiDAPTIV 在系统和存储层运行,无需修改模型代码或 AI 框架即可扩展 AI 工作负载。这对于使用成熟研究工作流程的学术团队来说尤其有价值。.

该方案如何帮助控制人工智能基础设施预算?

aiDAPTIV 通过减少对昂贵的高容量 GPU 的依赖,并提高现有硬件的利用率,从而降低资本支出并延长系统寿命。这使得预算有限的机构也能更轻松地运行高级 AI 工作负载。.

高等教育利益相关者为何应该观看本次网络研讨会?

本次网络研讨会提供了一套切实可行的方案,指导如何大规模部署私有本地人工智能。它深入剖析了如何降低成本、提高资源效率,以及如何在不依赖云服务商的情况下安全地开展人工智能研究和实验。.