最も効果的なリアルタイム AI 分析情報を得るために高性能ストレージが重要な理由と、Phison がそれをどのように容易にするかについて説明します。.

AIは、組織がデータと関わる方法を変革しています。しかし、次の大きな飛躍はモデル開発だけではありません。モデルがオンデマンドで情報にアクセスし、取得し、統合する方法が重要です。そこで登場するのが、検索拡張生成(RAG)です。.

RAGは、従来の生成AIと、外部データソースから関連するコンテキストをリアルタイムに取得する機能を組み合わせたものです。このハイブリッドアプローチにより、より正確で最新のコンテキストアウェアな応答が可能になり、エンタープライズ検索、会話型AI、カスタマーサポート、科学研究などのアプリケーションに最適です。しかし、RAGが大規模な環境で真の価値を提供するには、スマートモデルだけでは不十分です。大規模な非構造化データセットへの高速かつシームレスなアクセスをサポートするには、卓越したストレージパフォーマンスが必要です。.

RAG がこれほど要求が厳しいのはなぜでしょうか?

従来の生成モデルは事前学習済みのパラメータのみに基づいて動作しますが、RAGは推論プロセスに外部知識を注入します。ユーザーからのクエリが入力されると、システムはまず知識ベースから関連文書を取得し、クエリと取得したデータの両方を推論システムに入力します。 大規模言語モデル(LLM) 応答を生成します。.

この2段階のプロセスでは、モデルは社内Wikiやサポートログから学術ジャーナルや取引記録に至るまで、大規模でしばしば異種混合のデータセットと連携する必要があります。これらのデータセットは、以下の点をサポートする方法で保存する必要があります。

-

-

- 関連コンテンツの低遅延検索

- 推論パイプラインの高スループット処理

- 継続的に進化するデータソースの迅速な更新とインデックス作成

- 増大する AI 知識ベースに対応できるスケーラビリティ

-

従来のストレージでは対応しきれません。ハードドライブはボトルネックを引き起こします。従来のSSDは読み取り速度はまずまずですが、GPU搭載のAIクラスターにスケールアウトすると、耐久性やスループットが不足する可能性があります。RAGワークロードには、より高速でスマート、そしてより回復力の高いストレージが必要です。.

AIとRAGワークフローの高速化におけるSSDの役割

ストレージは現代のAIを支える目に見えないエンジンです。RAGにおいては、優れたストレージ性能が必須です。.

高性能NVMe SSDは、RAGパイプラインに必要な超低レイテンシと高いIOPS(1秒あたりの入出力操作数)を実現します。これにより、以下のことが可能になります。

-

-

- FAISSやVespaのような類似性検索ライブラリを使用した大規模な埋め込みの高速ベクトル検索

- AIワークフローにおける迅速な前処理と後処理段階

- シームレスな並列処理により、複数の GPU が I/O 競合なしでデータで飽和状態になる可能性がある

- 顧客対応やリアルタイム AI アプリケーションに不可欠な最小限の推論遅延

-

次世代 SSD は、PCIe Gen5 インターフェイスを活用することでこれをさらに改善し、レーンあたり最大 60 GB/秒の帯域幅を提供します。これは、高スループットの AI システムを飽和させ、GPU にフルスピードでデータを供給するには十分すぎるほどです。.

RAGにおいてデータ中心アーキテクチャが重要な理由

AI処理は、コンピューティング中心からデータ中心へと移行しました。RAGパイプラインでは、パフォーマンスはモデル自体ではなく、データフローの速度とインテリジェンスによって制限されることがよくあります。これには以下が含まれます。

-

-

- 取り込み – 新しいデータをどれだけ早くインデックス化して取得可能にできるか

- アクセス – 推論中に関連するコンテキストをどれだけ速く取得できるか

- ライフサイクル管理 – ホット、ウォーム、コールドストレージ層間でデータセットをいかに効率的に移動させるか

-

次世代SSD、特にAIユースケース向けに設計されたSSDが不可欠となるのはまさにこのためです。これらのSSDは、純粋な速度だけでなく、高度な耐久性、インテリジェントなキャッシュ、そして混合ワークロードを一貫して処理する能力も備えています。.

Phison が AI を迅速かつ大規模に構築する方法

よりスマートで高速、そして信頼性の高いAIを実現するための競争において重要なのは、モデルの重み付けやトレーニングデータだけではありません。インフラストラクチャが、それらのモデルに適切な情報を適切なタイミングでどれだけ効率的に提供できるかが重要です。RAGは、よりコンテキストアウェアなAIへの移行をリードしていますが、これを大規模に実現するには、思考マシンと同等の速度で動作するストレージレイヤーが必要です。.

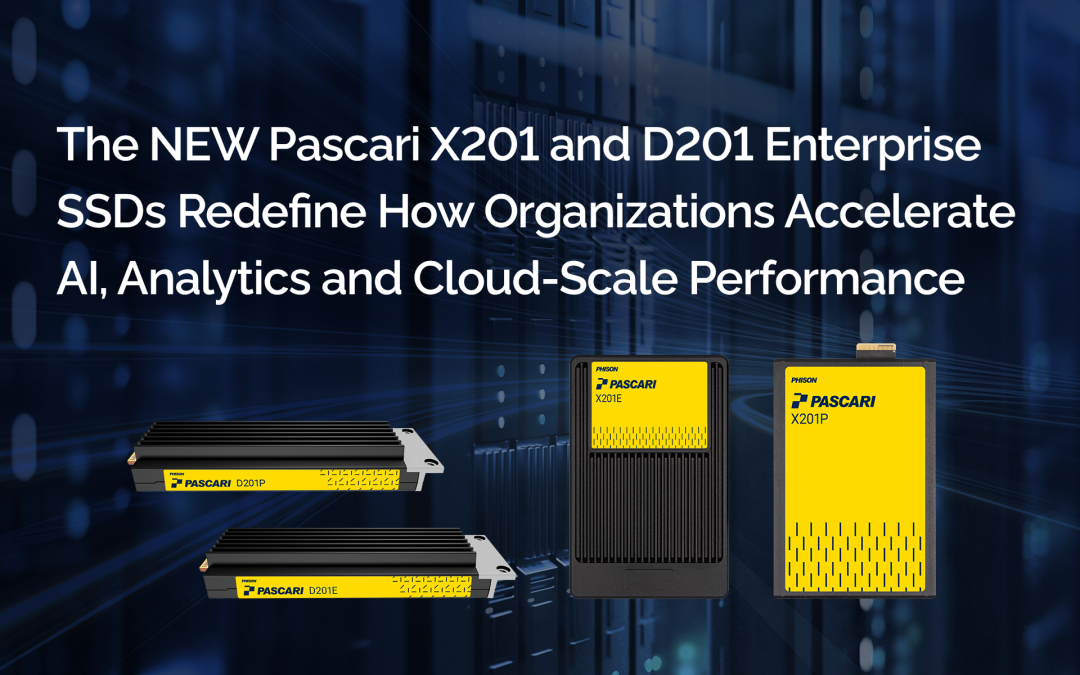

Phisonの次世代SSDポートフォリオは、AIおよびRAGワークフローの進化するニーズに特化して設計されています。低レイテンシ、高耐久性、AIに最適化されたスループットを実現するこれらのSSDにより、オンプレミス、ハイブリッドクラウド、エッジを問わず、組織はAIインフラストラクチャから最大限のパフォーマンスを引き出すことができます。.

Phison は AI ストレージ アーキテクチャのエンドツーエンドのサポートも提供し、企業を支援します。

-

-

- LLM および RAG パイプラインに合わせた高性能ストレージ スタックを設計する

- 速度とコストのバランスをとるインテリジェントな階層化を実装する

- データローカリティ戦略を有効にして、レイテンシとネットワーク依存を軽減します

- PCIe Gen5対応デバイスと高度なファームウェアチューニングを備えた将来を見据えたインフラストラクチャ

-

PhisonのAI最適化永続ストレージを活用している組織 Pascari エンタープライズ SSD そして aiDAPTIV+ キャッシュメモリ SSD 洞察を得るまでの時間を短縮し、よりスムーズなモデル展開を実現し、変化するデータニーズへのより迅速な対応を実現します。今日のビジネスに必要なスピード、レジリエンス、インテリジェンスを備え、

最も先進的な AI アーキテクチャを採用している Phison は、イノベーションのペースに追随するだけでなく、イノベーションのペースを設定することにも貢献しています。.

よくある質問(FAQ):

Phison が AI Infrastructure Tech Field Day に参加した主な目的は何でしたか?

Phisonは、AI推論とモデルトレーニングをオンプレミスで導入する際に機関が直面する実際的な課題に焦点を当てました。セッションでは、GPUメモリの制約、インフラコストの障壁、大規模言語モデルをローカルで実行することの複雑さについて議論しました。Phisonは、 aiDAPTIV 高価な GPU メモリへの依存を減らしながら AI の導入を簡素化するように設計されたコントローラー レベルのソリューションです。.

TechStrong TV の「ディレクターのハイライト」ウェビナーとは何ですか?

TechStrong TVは、PhisonのTech Field Dayセッションから厳選したハイライトをTech Field Day Insiderウェビナーとして制作しました。このウェビナーでは、最も関連性の高い技術的洞察を抽出し、専門家パネルによる解説も掲載されているため、ITリーダーや研究リーダーは、セッション全体を視聴することなく、アーキテクチャへの影響をより容易に理解できます。.

ウェビナーで紹介される Phison の講演者は誰ですか?

このウェビナーでは、Phison の技術リーダー 2 名にスポットライトを当てます。

- ブライアン・コックス, 手頃な価格のオンプレミス LLM トレーニングと推論を担当するソリューションおよび製品マーケティング担当ディレクター。.

- セバスチャン・ジャン, 、CTO が、aiDAPTIV を使用した LLM の微調整と推論のための GPU メモリ オフロード手法について説明します。.

オンプレミス AI が大学や研究機関にとって重要なのはなぜですか?

オンプレミスAIにより、機関はデータ主権を維持し、コンプライアンス要件を満たし、機密性の高い研究データを保護できます。また、長期的なクラウドコストを削減し、研究、教育、社内業務で使用されるAIワークロードの予測可能なパフォーマンスを実現します。.

ウェビナーで議論された主なインフラストラクチャの課題は何ですか?

主な課題としては、GPUメモリ容量の限界、インフラコストの高騰、LLMのローカル導入と管理の複雑さなどが挙げられます。これらの制約により、機関はパイロットプロジェクトを超えてAIイニシアチブを拡大することがしばしば困難になっています。.

Phison aiDAPTIV はどのようにして手頃な価格のオンプレミス AI トレーニングと推論を可能にするのでしょうか?

ファイソン aiDAPTIV コントローラーレベルで高性能NVMeストレージを使用してGPUメモリを拡張します。これにより、追加のGPUや特別なコーディングを必要とせずに、既存のハードウェア上で大規模なモデルを実行できるため、ローカルAI導入のコスト障壁が大幅に低減されます。.

「GPU メモリオフロード」とは実際にはどういう意味ですか?

GPUメモリオフロードにより、GPUメモリが飽和状態になった場合でも、AIワークロードはNVMeストレージを透過的に利用できるようになります。研究者やITチームにとって、これはパイプラインの再設計やコードの書き換えをすることなく、より大規模なモデルの学習や微調整が可能になることを意味します。.

aiDAPTIV では既存の AI フレームワークまたはコードに変更を加える必要がありますか?

いいえ。aiDAPTIVはシステム層とストレージ層で動作するため、モデルコードやAIフレームワークを変更することなくAIワークロードを拡張できます。これは、確立された研究ワークフローを使用している学術チームにとって特に有益です。.

このソリューションは AI インフラストラクチャの予算管理にどのように役立ちますか?

aiDAPTIVは、高価な大容量GPUへの依存を減らし、既存のハードウェアをより有効に活用することで、設備投資を削減しながらシステム寿命を延ばします。これにより、予算が限られている機関でも高度なAIワークロードをより容易に利用できるようになります。.

高等教育関係者がこのウェビナーを視聴する必要があるのはなぜですか?

このウェビナーでは、プライベートなオンプレミスAIを大規模に導入するための実践的なブループリントを提供します。コスト削減、リソース効率の向上、クラウドロックインのない安全なAI研究と実験の実現に関する実用的なインサイトを提供します。.