Erfahren Sie, warum Hochleistungsspeicher entscheidend ist, um die effektivsten Echtzeit-KI-Einblicke zu gewinnen – und wie Phison dies vereinfacht.

Künstliche Intelligenz (KI) verändert die Art und Weise, wie Unternehmen mit ihren Daten umgehen. Der nächste große Schritt liegt jedoch nicht allein in der Modellentwicklung, sondern vielmehr darin, wie diese Modelle Informationen bedarfsgerecht abrufen, verarbeiten und synthetisieren. Hier kommt die abrufbasierte Datengenerierung (Retrieval-Augmented Generation, RAG) ins Spiel.

RAG kombiniert traditionelle generative KI mit der Fähigkeit, relevante Kontextinformationen in Echtzeit aus externen Datenquellen abzurufen. Dieser hybride Ansatz ermöglicht präzisere, aktuellere und kontextbezogene Antworten und eignet sich daher ideal für Anwendungen wie Unternehmenssuche, dialogbasierte KI, Kundensupport und wissenschaftliche Forschung. Damit RAG jedoch in großem Umfang echten Mehrwert bietet, benötigt es mehr als nur intelligente Modelle. Es bedarf außergewöhnlicher Speicherleistung, um einen schnellen und nahtlosen Zugriff auf große, unstrukturierte Datensätze zu gewährleisten.

Was macht RAG so anspruchsvoll?

Im Gegensatz zu herkömmlichen generativen Modellen, die ausschließlich mit vorab trainierten Parametern arbeiten, integriert RAG externes Wissen in den Inferenzprozess. Bei einer Benutzeranfrage ruft das System zunächst relevante Dokumente aus einer Wissensbasis ab und speist anschließend sowohl die Anfrage als auch die abgerufenen Daten in einen großes Sprachmodell (LLM) um eine Reaktion hervorzurufen.

Dieser zweistufige Prozess erfordert die Interaktion des Modells mit umfangreichen, oft heterogenen Datensätzen, die von internen Wikis und Supportprotokollen bis hin zu wissenschaftlichen Zeitschriften und Transaktionsdatensätzen reichen. Diese Datensätze müssen so gespeichert werden, dass sie Folgendes unterstützen:

-

-

- Abruf relevanter Inhalte mit geringer Latenz

- Hochdurchsatzverarbeitung für Inferenzpipelines

- Schnelle Aktualisierungen und Indizierung für sich ständig weiterentwickelnde Datenquellen

- Skalierbarkeit zur Anpassung an wachsende KI-Wissensdatenbanken

-

Herkömmliche Speicherlösungen können da einfach nicht mithalten. Festplatten stoßen an ihre Grenzen. Ältere SSDs bieten zwar ordentliche Lesegeschwindigkeiten, stoßen aber bei der Skalierung auf GPU-gestützte KI-Cluster an ihre Grenzen, was Ausdauer und Durchsatz angeht. Für dynamische Workloads sind schnellere, intelligentere und robustere Lösungen erforderlich.

Die Rolle von SSDs bei der Beschleunigung von KI- und RAG-Workflows

Speicher ist der unsichtbare Motor moderner KI. Und gerade bei RAG ist eine hohe Speicherleistung unerlässlich.

Hochleistungsfähige NVMe-SSDs bieten die extrem niedrige Latenz und die hohe Anzahl an Ein-/Ausgabeoperationen pro Sekunde (IOPS), die für RAG-Pipelines unerlässlich sind. Sie ermöglichen:

-

-

- Schnelle Vektorsuchen in riesigen Einbettungen mithilfe von Ähnlichkeitssuchbibliotheken wie FAISS oder Vespa

- Schnelle Vor- und Nachbearbeitungsphasen im KI-Workflow

- Nahtlose Parallelverarbeitung, bei der mehrere GPUs ohne E/A-Konflikte mit Daten voll ausgelastet werden können.

- Minimale Latenz bei der Inferenz, entscheidend für kundenorientierte oder Echtzeit-KI-Anwendungen

-

SSDs der nächsten Generation verbessern dies noch weiter, indem sie PCIe Gen5-Schnittstellen nutzen und Bandbreiten von bis zu 60 GB/s pro Lane bieten – mehr als genug, um KI-Systeme mit hohem Durchsatz auszulasten und GPUs mit voller Geschwindigkeit zu versorgen.

Warum datenzentrierte Architektur in RAG wichtig ist

Die KI-Verarbeitung hat sich von rechenzentriert zu datenzentriert verlagert. In RAG-Pipelines wird die Leistung oft nicht durch das Modell selbst, sondern durch die Geschwindigkeit und Intelligenz des Datenflusses begrenzt. Dazu gehören:

-

-

- Datenerfassung – Wie schnell neue Daten indexiert und abrufbar gemacht werden können

- Zugriff – Wie schnell relevanter Kontext während der Inferenz abgerufen werden kann.

- Lebenszyklusmanagement – Wie effizient Datensätze zwischen Hot-, Warm- und Cold-Storage-Ebenen verschoben werden.

-

Hier erweisen sich SSDs der nächsten Generation, insbesondere solche, die für KI-Anwendungen entwickelt wurden, als unverzichtbar. Sie bieten nicht nur hohe Geschwindigkeiten, sondern auch eine hohe Ausdauer, intelligentes Caching und die Fähigkeit, gemischte Arbeitslasten zuverlässig zu verarbeiten.

Wie Phison Ihnen hilft, KI schnell und skalierbar zu entwickeln

Im Wettlauf um intelligentere, schnellere und vertrauenswürdigere KI geht es nicht nur um Modellgewichte und Trainingsdaten. Entscheidend ist, wie gut Ihre Infrastruktur diese Modelle mit den richtigen Informationen zum richtigen Zeitpunkt versorgen kann. RAG treibt den Wandel hin zu kontextbezogener KI voran, doch um dies in großem Umfang zu realisieren, benötigen Sie eine Speicherschicht, die genauso schnell arbeitet wie Ihre KI-Systeme.

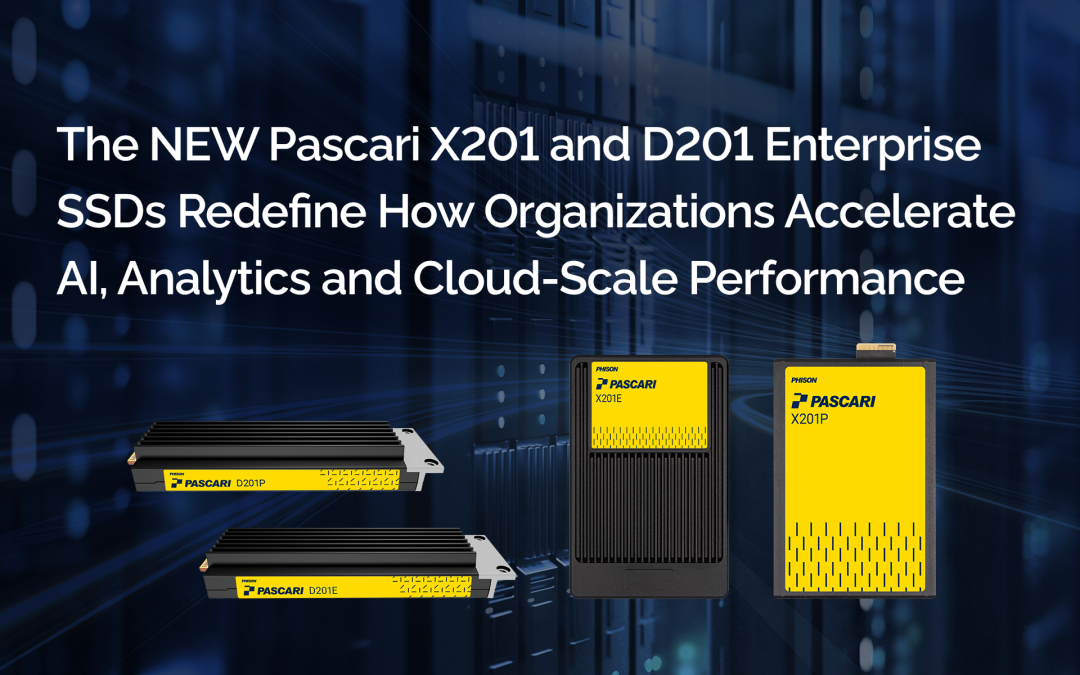

Phisons Portfolio an SSDs der nächsten Generation wurde speziell für die sich wandelnden Anforderungen von KI- und RAG-Workflows entwickelt. Dank ihrer geringen Latenz, hohen Ausdauer und des für KI optimierten Durchsatzes ermöglichen diese SSDs Unternehmen, die maximale Leistung aus ihrer KI-Infrastruktur herauszuholen – ob On-Premise, in einer Hybrid-Cloud oder am Edge.

Phison bietet außerdem umfassende Unterstützung für KI-Speicherarchitekturen und hilft Unternehmen dabei:

-

-

- Entwicklung von Hochleistungsspeichersystemen, die auf LLM- und RAG-Pipelines zugeschnitten sind.

- Implementieren Sie ein intelligentes Stufenmodell, um Geschwindigkeit und Kosten in Einklang zu bringen.

- Aktivieren Sie Strategien zur Datenlokalisierung, um Latenz und Netzwerkabhängigkeit zu reduzieren.

- Zukunftssichere Infrastruktur mit PCIe Gen5-fähigen Geräten und fortschrittlichem Firmware-Tuning

-

Organisationen, die Phisons KI-optimierten persistenten Speicher nutzen Pascari Enterprise-SSDs Und aiDAPTIV+ Cache-Speicher-SSDs Schnellere Erkenntnisgewinnung, reibungslosere Modellimplementierungen und agilere Reaktionen auf sich ändernde Datenanforderungen. Mit der Geschwindigkeit, Ausfallsicherheit und Intelligenz, die für die heutigen Anforderungen erforderlich sind.

Mit seinen hochentwickelten KI-Architekturen hält Phison nicht nur mit dem Innovationstempo Schritt, sondern trägt aktiv dazu bei, es zu bestimmen.

Häufig gestellte Fragen (FAQ):

Worauf lag der Schwerpunkt der Teilnahme von Phison am AI Infrastructure Tech Field Day?

Phison konzentrierte sich auf die praktischen Herausforderungen, mit denen Institutionen bei der Implementierung von KI-Inferenz und Modelltraining vor Ort konfrontiert sind. Die Sitzungen behandelten GPU-Speicherbeschränkungen, Infrastrukturkostenbarrieren und die Komplexität der lokalen Ausführung großer Sprachmodelle. Phison stellte vor aiDAPTIV als Controller-Lösung, die die KI-Implementierung vereinfachen und gleichzeitig die Abhängigkeit von teurem GPU-Speicher reduzieren soll.

Was ist das TechStrong TV-Webinar “Director's Highlights”?

TechStrong TV hat aus den Tech Field Day-Sessions von Phison eine Auswahl der Highlights zusammengestellt und als Tech Field Day Insider-Webinar präsentiert. Dieses Format fasst die wichtigsten technischen Erkenntnisse zusammen und beinhaltet Kommentare von Experten, wodurch IT- und Forschungsleiter die architektonischen Implikationen leichter erfassen können, ohne sich die kompletten Sessions ansehen zu müssen.

Wer sind die Phison-Referenten, die im Webinar vorgestellt werden?

Das Webinar stellt zwei technische Führungskräfte von Phison vor:

- Brian Cox, Direktor für Lösungs- und Produktmarketing, der kostengünstige LLM-Schulungen vor Ort und Schlussfolgerungen anbietet.

- Sébastien Jean, CTO, der GPU-Speicherauslagerungstechniken für LLM-Feinabstimmung und Inferenz mit aiDAPTIV erläutert.

Warum ist KI vor Ort für Universitäten und Forschungseinrichtungen wichtig?

On-Premises-KI ermöglicht es Institutionen, Datensouveränität zu wahren, Compliance-Anforderungen zu erfüllen und sensible Forschungsdaten zu schützen. Sie reduziert zudem langfristig die Cloud-Kosten und bietet eine vorhersehbare Leistung für KI-Workloads in Forschung, Lehre und internen Abläufen.

Welche zentralen Herausforderungen im Bereich der Infrastruktur wurden im Webinar besprochen?

Zu den zentralen Herausforderungen zählen die begrenzte Speicherkapazität von GPUs, die steigenden Infrastrukturkosten und die Komplexität der lokalen Bereitstellung und Verwaltung von LLMs. Diese Einschränkungen hindern Institutionen häufig daran, KI-Initiativen über Pilotprojekte hinaus auszuweiten.

Wie ermöglicht Phison aiDAPTIV kostengünstiges KI-Training und Inferenz vor Ort?

Phison aiDAPTIV Der GPU-Speicher wird durch den Einsatz von leistungsstarkem NVMe-Speicher auf Controller-Ebene erweitert. Dadurch können große Modelle auf vorhandener Hardware ausgeführt werden, ohne dass zusätzliche GPUs oder spezielle Programmierung erforderlich sind. Dies senkt die Kosten für den lokalen Einsatz von KI erheblich.

Was bedeutet “GPU-Speicherauslagerung” in der Praxis?

Durch die GPU-Speicherauslagerung können KI-Workloads NVMe-Speicher transparent nutzen, wenn der GPU-Speicher ausgelastet ist. Für Forscher und IT-Teams bedeutet dies, dass größere Modelle trainiert oder feinabgestimmt werden können, ohne Pipelines neu gestalten oder Code umschreiben zu müssen.

Erfordert aiDAPTIV Änderungen an bestehenden KI-Frameworks oder am Code?

Nein. aiDAPTIV arbeitet auf der System- und Speicherebene und ermöglicht so die Skalierung von KI-Workloads, ohne dass Modellcode oder KI-Frameworks angepasst werden müssen. Dies ist besonders wertvoll für akademische Teams, die etablierte Forschungsworkflows nutzen.

Wie trägt diese Lösung zur Kontrolle der Budgets für KI-Infrastruktur bei?

Durch die Reduzierung der Abhängigkeit von teuren Hochleistungs-GPUs und die bessere Auslastung vorhandener Hardware senkt aiDAPTIV die Investitionskosten und verlängert gleichzeitig die Systemlebensdauer. Dadurch werden anspruchsvolle KI-Workloads auch für Institutionen mit begrenzten Budgets zugänglicher.

Warum sollten Akteure im Hochschulbereich dieses Webinar ansehen?

Das Webinar bietet einen praxisnahen Leitfaden für den großflächigen Einsatz privater, lokaler KI-Lösungen. Es liefert umsetzbare Erkenntnisse zur Kostensenkung, Verbesserung der Ressourceneffizienz und Ermöglichung sicherer KI-Forschung und -Experimente ohne Cloud-Abhängigkeit.